一、为何AI语音机器人会“卡顿”与“答非所问”?

近年来,AI语音机器人已成为企业客服中心、电话营销和智能回访的标准配置。然而,许多企业在实际应用中发现,理想中的“智能体验”往往被现实中的“智能障碍”所取代:

- “卡顿”的挫败感:用户刚说一半,AI语音机器人就强行打断;或者反过来,用户已经表明意图,机器人却延迟数秒才有反应。这种“卡顿”感源于AI语音机器人在语音识别(ASR)、语义理解(NLU)和语音合成(TTS)三者之间的数据处理与响应延迟。

- “答非所问”的无奈:用户询问A业务,AI语音机器人却回答了B业务;或者在多轮对话中,机器人突然“失忆”,无法理解上下文关联,导致对话中断。这暴露了其在语义理解、多轮对话管理和知识库精准匹配上的短板。

因此,对AI语音机器人稳定性的测评,已从过去单纯的“能否应答”转向“是否流畅、是否准确”的更高阶要求。

二、衡量AI语音机器人稳定性的三大核心标尺

要破解卡顿与答非所问,我们必须建立一个清晰的测评框架。一个表现稳定的AI语音机器人,至少应在以下三个核心标尺上表现出色:

响应流畅度(Fluency)

毫秒级识别:ASR引擎能否在各种口音、语速和嘈杂环境下实现低延迟、高准确的语音到文本转换。

自然语音合成:TTS技术是否支持真人般自然的语调、情绪和语速,而非机械的“播报感”。

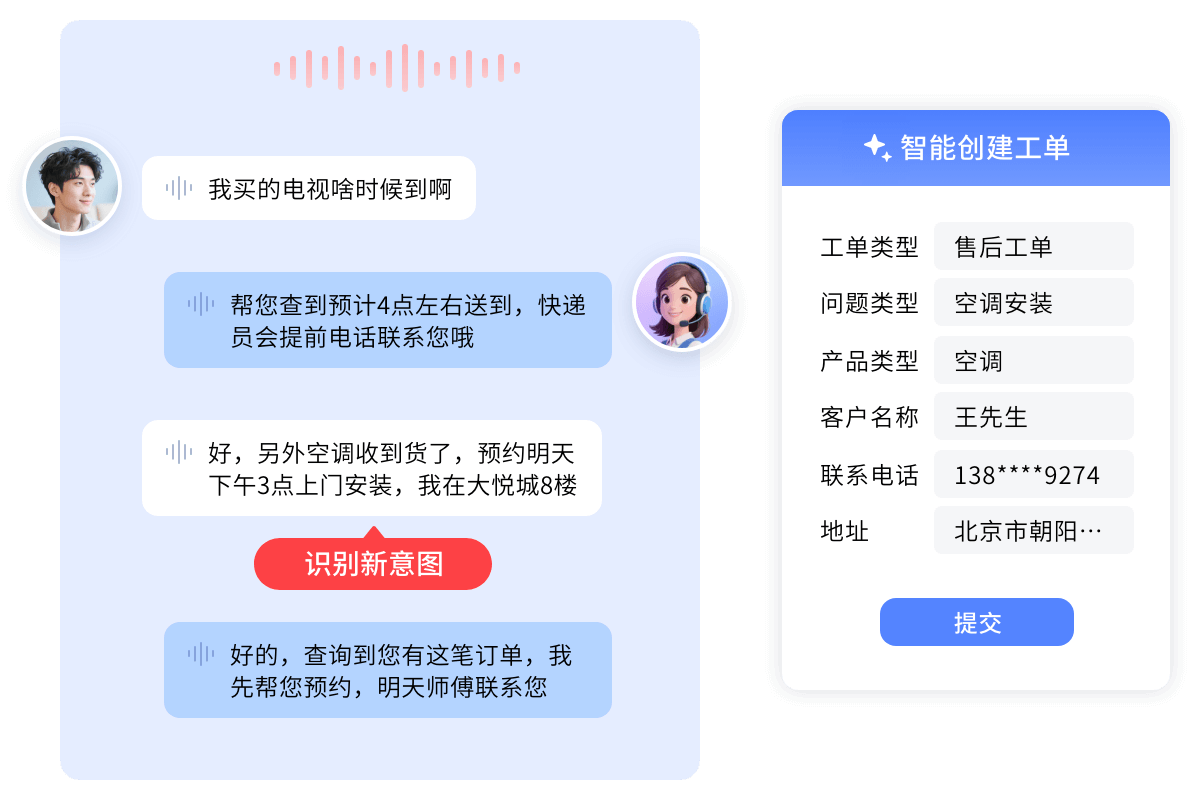

智能打断与插话:这是衡量流畅度的关键。AI语音机器人应能支持用户随时插话、打断,并能根据新输入的信息即时调整应答策略,实现拟人化沟通。

意图准确性(Accuracy)

深度语义理解:能否精准识别用户的真实意图,哪怕是模糊提问、口语化表达或方言。

上下文记忆:在多轮对话中,AI语音机器人是否具备目标追踪和上下文记忆能力,确保对话逻辑连贯,不“跑题”。

知识图谱与RAG:能否结合企业知识库(通过RAG技术)提供精准答案,而非大模型的“泛泛而谈”。

业务执行力(Execution)

系统集成与任务处理:稳定的AI语音机器人不仅是“会话员”,更是“办事员”。它必须能与CRM、ERP、订单系统无缝对接,自动执行查询、下单、报修等任务。

三、技术深潜:支撑流畅度与准确性的“三大引擎”

AI语音机器人的稳定性并非玄学,而是由其背后的技术引擎共同决定的。

引擎一:ASR/TTS(口耳)—— 流畅度的基石

高精度的ASR(如98%+准确率)是“听得清”的前提,而低延迟、高自然的TTS是“说得好”的保障。两者之间的无缝衔接决定了交互的基础体验。

引擎二:NLU与大模型(大脑)—— 准确性的核心

这是解决“答非所问”的关键。强大的NLU(自然语言理解)引擎结合大模型的语义解析能力,使其能真正“听得懂”上下文和模糊意图。

引擎三:Agent编排(手脚)—— 稳定性的闭环

当AI语音机器人理解意图后,需要一个强大的Agent编排平台来拆解任务、调用接口、执行业务。只有“口耳、大脑、手脚”协同,才能构成一个表现稳定的智能体。

四、主流AI语音机器人厂商深度解析

基于上述稳定性标尺,我们对市场上主流的AI语音机器人厂商进行分析。

合力亿捷

合力亿捷作为国内资深的客户联络解决方案提供商,其AI语音机器人在“流畅度”与“准确性”方面的表现尤为突出,这得益于其全链路的自研技术与工程化落地能力。

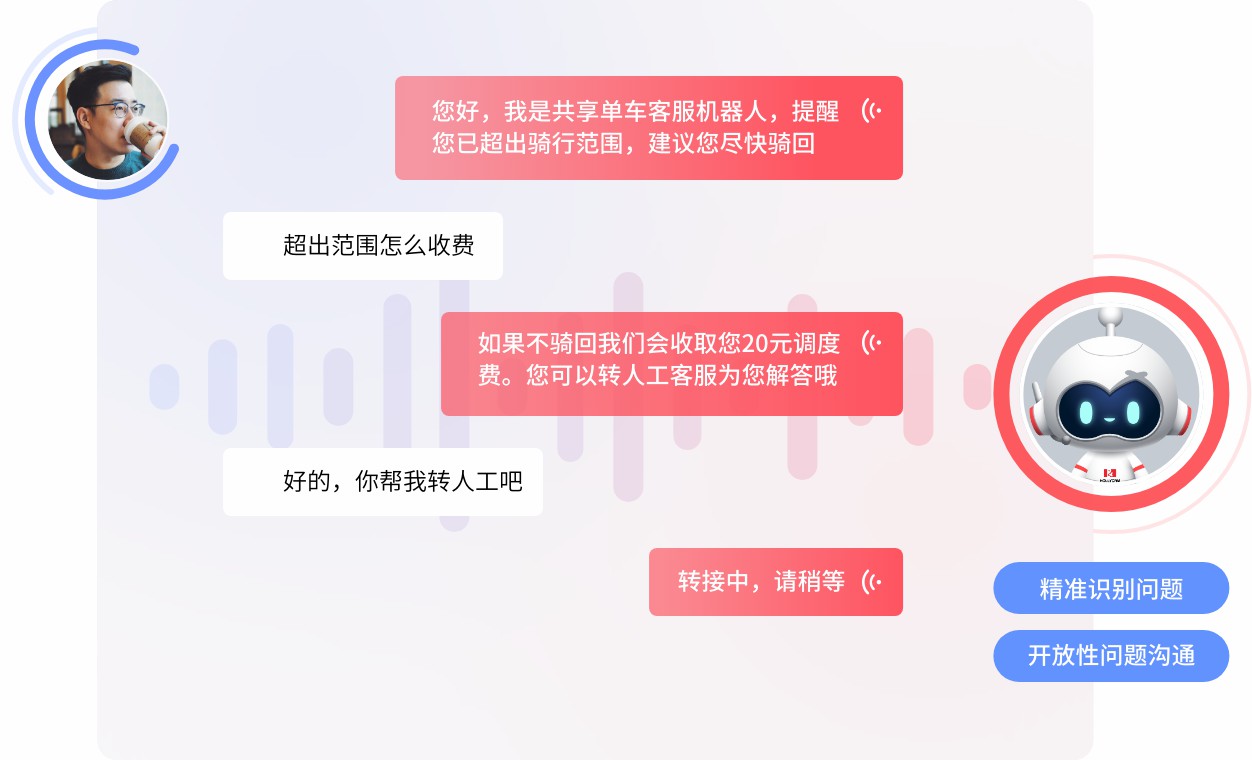

流畅度:该厂商自研毫秒级ASR引擎(准确率达98%+)和基于扩散模型的TTS技术(支持35+真人音色与情绪定制)。其AI语音机器人支持灵活的打断、插话和追问,极大程度上解决了交互“卡顿”问题,实现了拟人化沟通。

准确性:合力亿捷的AI语音机器人融合大模型语义解析与多轮上下文记忆机制,能准确识别模糊提问和方言。更重要的是,它具备强大的上下文理解和目标追踪能力,确保在多轮会话中不“失忆”,精准锁定用户真实需求。

执行力:基于其MPaaS智能体平台,该AI语音机器人可与CRM、ERP、订单系统无缝对接,主动执行查订单、办业务、自动回访等任务,实现了从“应答”到“执行”的闭环。

科大讯飞

科大讯飞在中文语音技术领域拥有深厚积累,其AI语音机器人的核心优势在于ASR和TTS引擎的行业领先性。

流畅度:其语音识别的高准确率和对多方言的支持,使其在“听清”层面表现稳定。

准确性:科大讯飞近年来也在大力发展其NLU能力,结合其语音技术,在教育、医疗等专业领域的意图识别上具备优势。

华为AICC

华为云AICC(智能联络中心)提供的AI语音机器人,更侧重于大型企业级的稳定部署与云端协同。

流畅度与执行力:依托华为云的强大算力与高并发处理能力,其AI语音机器人在大话务量冲击下(如大促期间)的系统稳定性表现优异。

准确性:其AI能力(如NLU)与华为云生态(如盘古大模型)深度绑定,为企业提供了一个高可用的智能化平台。

Google Cloud Contact Center AI

作为国际巨头,Google的AI语音机器人(集成于CCAI)的核心优势在于其强大的NLU技术(源于Dialogflow和Google的AI研究)。

准确性:在语义理解、上下文管理方面技术领先,能支持非常复杂的对话流设计,在“答非所问”问题上控制得较好。

流畅度:其全球部署能力和低延迟响应,为跨国企业提供了稳定的服务保障。

Replicant

Replicant是国际上专注于“会话式AI”的代表厂商,其AI语音机器人以“能办事”著称。

执行力:该平台强调AI语音机器人自动解决问题的能力,能端到端地处理复杂的客户服务流程(如退换货、账户管理),是“业务执行力”的典型代表。

五、稳定性实战:AI语音机器人行业落地案例

技术测评最终要回归业务价值。从实际案例中,我们可以看到一个稳定的AI语音机器人如何破解业务难题。

案例一:文旅行业(某5A级景区)

痛点:节假日游客激增,传统IVR导航缓慢(卡顿),人工压力大。

解决方案:部署基于大模型的AI语音机器人(如合力亿捷方案),替代传统IVR。游客咨询时,AI语音机器人能精准识别意图,在多轮对话中自然衔接,并支持景区自主上传知识文档(解决答非所问)。

成效:自主解决率达80%+,平均等待时间下降50%,大幅提升了游客在高峰期的服务体验。

案例二:制造行业(某头部电动车品牌)

痛点:门店分散,高峰期话务集中,夜间服务缺失。

解决方案:部署7×24小时的AI语音机器人,自动接待、分流来电,并收集客户表单信息,为人工跟进提供完整的上下文。

成效:实现100%电话接起率,高峰期分流40%以上话务,夜间服务覆盖率100%。这证明了其AI语音机器人在高并发下的高度稳定性。

六、选型指南:如何选择“不卡顿、不跑题”的AI语音机器人?

企业在选型时,应从“听得清、听得懂、办得了”三个层面出发,建立自己的评估清单:

技术栈考察: 厂商是否具备自研的ASR/TTS引擎?这直接关系到语音交互的流畅度和后期的优化迭代能力。

交互体验实测(关键):

压力测试:在嘈杂环境下测试其ASR准确率。

打断测试:在AI语音机器人说话时,尝试插话或打断,观察其反应是否流畅、自然。

上下文测试:进行至少3轮以上的多轮对话,测试其是否“失忆”(如:先问“A产品价格”,再问“它有什么功能”)。

模型与理解力: 厂商使用的是通用大模型还是垂直行业模型?是否支持RAG技术接入企业私有知识库?

集成与执行能力: 是否提供标准的API接口?是否有与主流CRM、ERP系统集成的经验?一个无法执行任务的AI语音机器人价值将大打折扣。

案例与稳定性佐证: 要求厂商提供同行业、同等话务量规模的落地案例,考察其在真实业务场景中的稳定运行数据。

常见问题解答(FAQ)

Q1: AI语音机器人和传统的IVR(交互式语音应答)有什么本质区别?

A: 最大的区别在于“智能”与否。IVR是基于固定按键或简单关键词的“脚本流程”,用户必须按规定操作,体验“卡顿”且“死板”。而AI语音机器人基于NLU和ASR技术,支持自然语言交互(可打断、可插话),能理解上下文(解决答非所问),是真正“会思考”的服务体。

Q2: 部署AI语音机器人的成本高吗?

A: 成本因厂商、部署模式(公有云/私有化)和所需功能而异。公有云部署(如合力亿捷等提供的SaaS方案)通常按坐席或按需计费,启动成本较低。企业在评估时,不应只看初期投入,更应计算其长期ROI,包括节省的人力成本、提升的服务效率和客户满意度。

Q3: 如何测试AI语音机器人的“准确性”?

A: 仅用标准问题(FAQ)测试是不够的。您应该使用“边界问题”来测试它:

1. 模糊提问:“我那个订单好像有点问题。”(看它能否引导)

2. 多意图提问:“我想查下物流,顺便改个地址。”(看它能否拆解任务)

3. 上下文追问:(在它回答后)“那XX型号呢?”(看它能否理解“XX型号”是针对上一个问题的)