根据 Gartner报告显示,全球 67% 的企业已将 AI 智能客服纳入客户服务核心工具,但平均响应时间超过 8 秒的现状,仍导致用户满意度下降 12%。

面对数据孤岛与低效系统的双重挑战,分布式架构逐渐成为破局关键,推动响应速度从秒级迈向毫秒级闭环。这一技术革新,正重塑电商、零售、制造等行业的客户服务模式。

一、现状与挑战:响应延迟背后的数据孤岛困局

响应速度为何难以突破?

当前 AI 智能客服系统的响应延迟,往往源于以下核心问题:

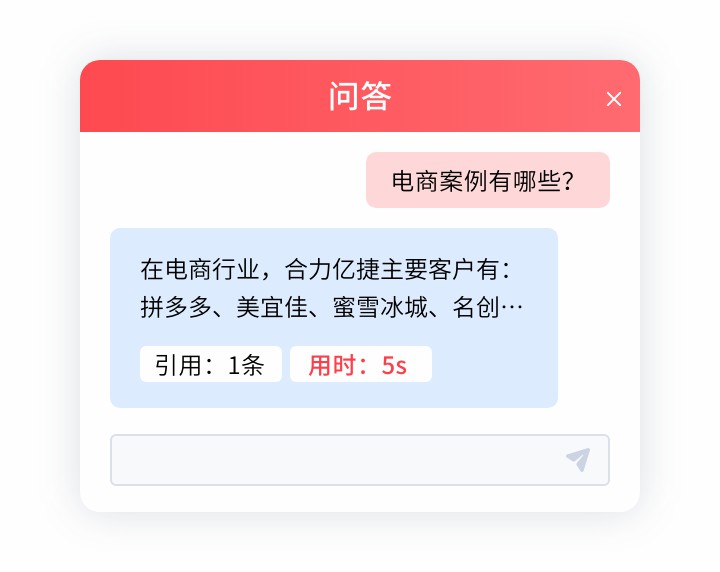

1、数据孤岛林立:企业内部系统(如 CRM、ERP、订单系统)数据无法互通,AI 需跨多平台调用信息,耗时增加 40% 以上。

2、集中式架构瓶颈:单点服务器处理高并发请求时易过载,电商大促期间响应时间甚至超过 15 秒。

3、算法复杂度与资源分配失衡:自然语言处理(NLP)模型参数量增大,但算力资源调度缺乏动态优化。

某零售企业在 “双 11” 高峰时段,因库存数据与客服系统割裂,导致用户查询订单状态的平均响应时间达到 9.2 秒,退货率上升 8%。

麦肯锡调研显示,数据未打通的企业客户服务成本增加 23%,且跨部门协作效率降低 35%。尤其在制造业,售后问题需关联生产、物流数据时,响应延迟直接影响客户信任。

二、破局路线图:分布式架构如何实现毫秒级闭环?

1、技术架构升级:从集中式到分布式

分布式架构通过去中心化节点协同,突破传统系统瓶颈:

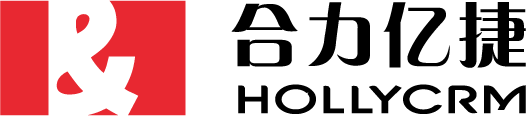

微服务拆分:将 AI 客服拆分为独立模块(如意图识别、数据查询、会话管理),并行处理减少链路依赖。

边缘计算部署:在本地节点预处理高频请求(如物流状态查询),降低云端往返耗时。

实时数据总线:通过 Kafka、RabbitMQ 等中间件实现跨系统数据流同步,打破数据孤岛。

某互联网平台采用分布式架构后,用户问题识别时间从 2.1 秒降至 0.3 秒,数据查询速度提升 5 倍。

2、优化策略:算法与工程协同

动态负载均衡:根据实时流量分配算力资源,避免高峰期服务降级。

模型轻量化:使用蒸馏技术压缩 NLP 模型体积,响应速度提升 60% 的同时保持准确率。

缓存机制:高频问题答案预存于内存数据库(如 Redis),命中率超 85% 时可实现毫秒级反馈。

三、垂直行业实战:场景化解决方案

1、电商行业:大促时段的秒杀响应

痛点:瞬时咨询量激增,库存、优惠券数据分散导致响应延迟。

方案:分布式架构支持弹性扩容至 10 万级 TPS(每秒事务处理量),结合实时数据同步,确保促销规则秒级更新。

2、制造业:售后问题溯源

痛点:设备故障需调取生产批次、质检记录等多系统数据。

方案:通过 API 网关整合 MES(制造执行系统)与客服平台,将数据查询时间从 7 秒压缩至 1 秒内。

3、金融行业:合规与效率平衡

痛点:风控审核需跨多部门数据核验,人工介入率高。

方案:分布式架构部署隐私计算模块,在数据不泄露的前提下完成联合查询,响应速度提升至 2 秒。

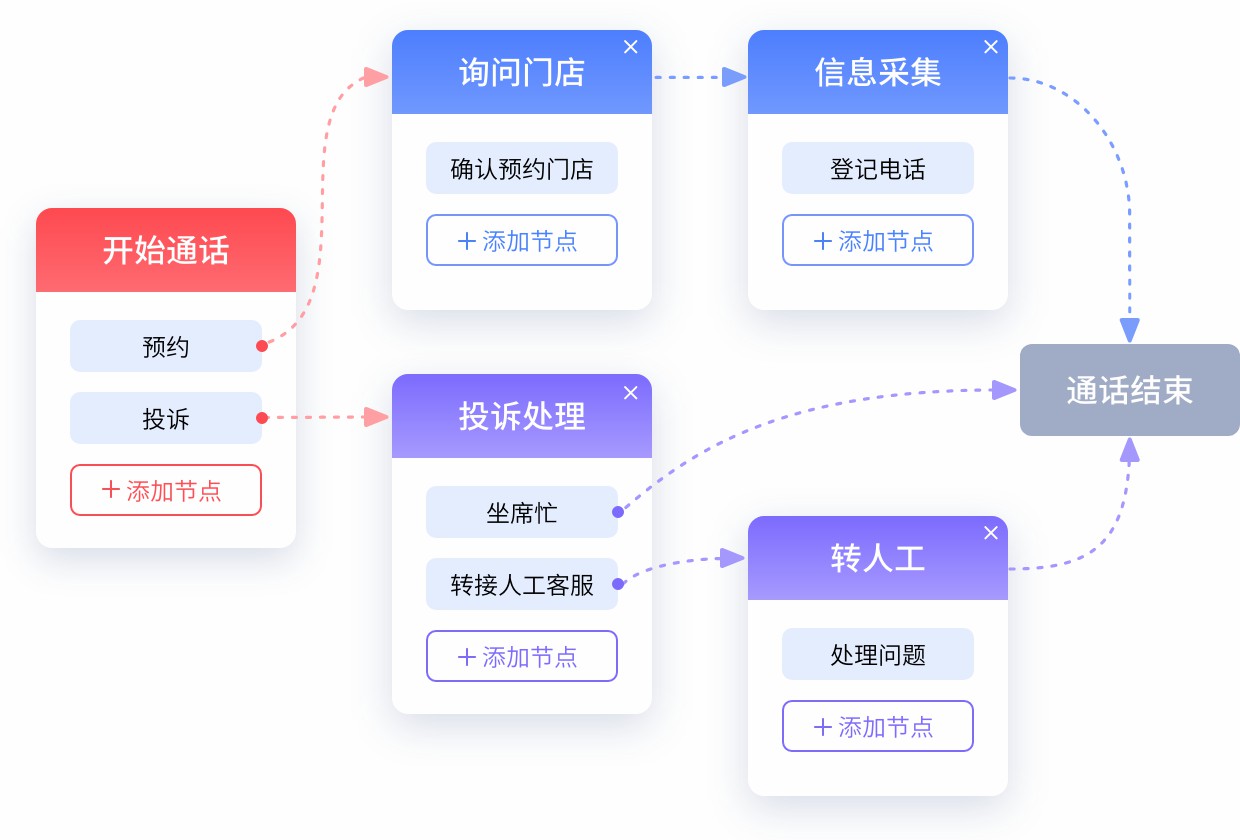

四、实战问答:直击核心疑问

Q:AI 客服响应时间为何难以低于 8 秒?

A:主因是数据孤岛导致的跨系统调用耗时,以及集中式架构在高并发下的性能瓶颈。

Q:分布式架构会增加实施成本吗?

A:初期投入较高,但长期 ROI 显著。某企业上线后人力成本降低 30%,用户留存率提升 18%。

Q:如何避免分布式系统的数据一致性问题?

A:采用分布式事务框架(如 Seata),并设置异步补偿机制,确保最终一致性。

Q:中小型企业如何选择技术方案?

A:优先采用云服务商的托管式分布式方案(如 合力亿捷云客服方案),降低运维复杂度。

Q:响应速度提升后如何保证服务质量?

A:通过 A/B 测试优化算法,并设置异常回退机制(如超 3 秒自动转人工)。

Gartner 预测,到 2025 年,70% 的 AI 客服将实现 “感知 - 决策 - 执行” 全链路自动化。这意味着:

多模态交互:整合语音、图像、文本,用户问题识别准确率突破 95%。

主动服务:通过数据分析预判用户需求,从 “被动应答” 转向 “主动建议”。

自适应学习:分布式架构支持模型持续迭代,冷启动周期缩短 50%。

通过技术与场景化方案的深度结合,企业可在响应速度与数据治理的博弈中破局,构建真正以客户为中心的 AI 服务体系。