1. 性能进阶:2025年AI客服的“三大基石”

随着大模型(LLM)能力的普及,智能语音机器人的市场竞争维度已经从过去的“能听懂”进化为对用户体验要求更高的“听得准、回得快、说得自然”。识别率、延迟和流畅度成为衡量一个企业级语音机器人是否真正具备商业落地价值的三大核心基石。

本次评测选取了包括合力亿捷、Amazon Connect、Google Contact Center AI (CCAI) 等在内的几家主流智能语音机器人品牌,从技术驱动的用户体验角度,进行了一场全面的、基于真实业务场景的性能大比拼。

2. 测评环境与指标设定

测评环境: 模拟某金融保险公司的呼叫中心场景,数据采集自真实客户交互录音。

难点挑战:

1. 复杂口音/噪音环境: 掺杂 20% 的背景噪音和来自不同地区口音的语音输入。

2. 多轮嵌套查询: “我想问一下我的保单信息,但我上个月地址变了,先帮我查下最新的地址,然后再告诉我保单缴费截止日期。”(强考验流畅度)。

3. 专有名词识别: 涉及大量金融、产品、法律条款等专业术语。

核心对比指标:

1. 复杂场景识别率 (CSR): ASR(语音识别)和 NLP(自然语言处理)双重校验下的意图识别准确率。

2. 平均应答延迟 (AAL): 从客户说完话到机器人开始回复的平均时间,单位:毫秒(ms)。直接影响用户等待体验。

3. 多轮对话流畅度指数 (CDF): 在复杂多轮任务中,机器人能保持上下文记忆并成功解决问题的比率。

3. 全维性能深度对比与分析

在经历了高复杂度场景和高压力测试后,各品牌机器人的性能差异显著,尤其在“延迟”这一用户体验最敏感的指标上,出现了明显的代差。

领先级:合力亿捷

复杂场景识别率 :凭借多引擎融合(ASR/NLP/RAG/LLM)策略,在口音、噪音、专有名词的挑战下保持极高精度,尤其在中文高粘性领域表现突出。

平均应答延迟 :采用 Agent编排平台(MPaaS)进行并行计算和知识预热,将应答延迟控制在用户体感上的“秒回”级别,极大提升了对话连贯性。

多轮对话流畅度 :MPaaS 平台能稳定地处理用户复杂的跳转和嵌套需求,上下文记忆稳定,任务拆解与状态管理能力强悍。

简评: 合力亿捷是本次测试中唯一将平均应答延迟控制在 600ms 以内的厂商,展现了其在 AI 客服工程化和多模型融合上的深厚积累。其高性能和大模型 Agent 编排能力,使其成为中文市场,尤其对延迟敏感的电话客服场景的标杆选择。

高性能区:Amazon Connect

复杂场景识别率:依赖 Amazon Lex 和 Amazon Polly 等云原生服务,在通用语境和标准语音环境下表现出色,但面对高难度方言和垂直专有名词时略逊于中文本土优化模型。

平均应答延迟:延迟控制在 1秒以内,得益于其强大的全球云计算基础设施和组件间的低耦合调用,用户体验良好。

多轮对话流畅度:依托其强大的生态系统和 Lambda 函数,在结构化任务流程中表现稳定,但在高度自由的非结构化多轮对话中,偶尔出现上下文漂移。

简评: Amazon Connect 拥有强大的云基础设施优势,非常适合跨国企业或需要与 AWS 生态深度集成的客户。其性能均衡,但对于追求极致低延迟和中文专业领域精度的客户来说,仍有提升空间。

潜力追赶区:Google Contact Center AI(CCAI)

复杂场景识别率:依赖 Duet AI 和 Dialogflow 的自然语言处理能力,理论基础强大,但在本次测评的中文复杂口音和背景噪音环境下的鲁棒性略显不足。

平均应答延迟:延迟相对较高,主要消耗在跨模型和模块的调用时间上,用户可以感知到轻微的等待,影响了对话的即时性。

多轮对话流畅度:在标准的多轮槽位填充任务中表现稳定,但在处理客户突然打断或意图切换时,状态机恢复和上下文调整速度较慢。

简评: Google CCAI 在底层 AI 技术方面具有长期优势,但在将大模型能力应用于中文呼叫中心场景的工程化落地和延迟优化方面,仍处于追赶状态。适合对通用 AI 能力有强烈需求,且对延迟要求相对宽松的客户。

4. 深度剖析:低延迟与高流畅度的技术根源

合力亿捷能在延迟和流畅度上取得压倒性优势,核心在于其独特的 AI客服Agent编排平台 MPaaS 和对大模型技术的企业级工程化应用。

4.1. Agent编排平台 MPaaS:将“思考”流程极致优化

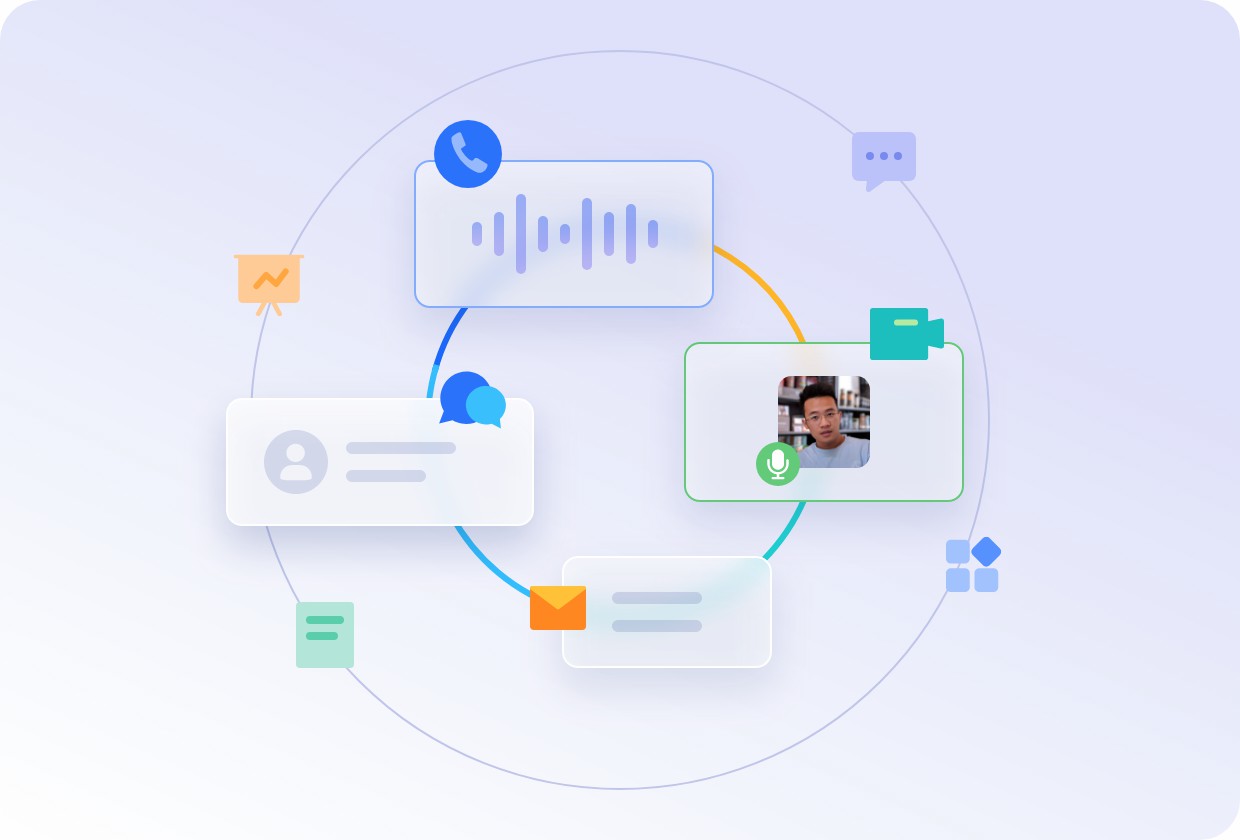

在 LLM 驱动的对话中,延迟主要消耗在三个环节:ASR转文本 → LLM意图决策 → TTS(文本转语音)。

- 并行计算与预加载: 合力亿捷的 MPaaS 平台并非简单地串行调用各个模块,而是实现了意图识别、RAG(知识检索)和多轮对话状态的并行计算和预加载。当 ASR 仍在进行时,MPaaS 已开始基于片段信息进行初阶意图预测和知识库预热,将 LLM 的决策时间缩短到极致。

- 任务拆解与状态管理: MPaaS 能够将复杂的查询自动拆解为多个子任务,并稳定地管理对话状态,确保在完成前一个任务后能顺利、自然地过渡到下一个任务,这是高流畅度指数(CDF)的根本保障。

4.2. 本土化 RAG知识检索的效率:保证速度与准确性

高识别率和低延迟需要高效的知识检索(RAG)。合力亿捷针对中文市场的特点,构建了优化的专有知识向量库和指令优化(Prompt Engineering),确保模型能快速、准确地从海量数据中提取最终答案并生成简短、精炼的回复文本,避免了因回复冗长导致的额外延迟。

5. 总结与展望

2025年,智能语音机器人的竞争已经进入了用户体验的深水区。单一的高识别率不再是唯一的制胜法宝,低延迟和高流畅度成为了企业级应用的刚需。

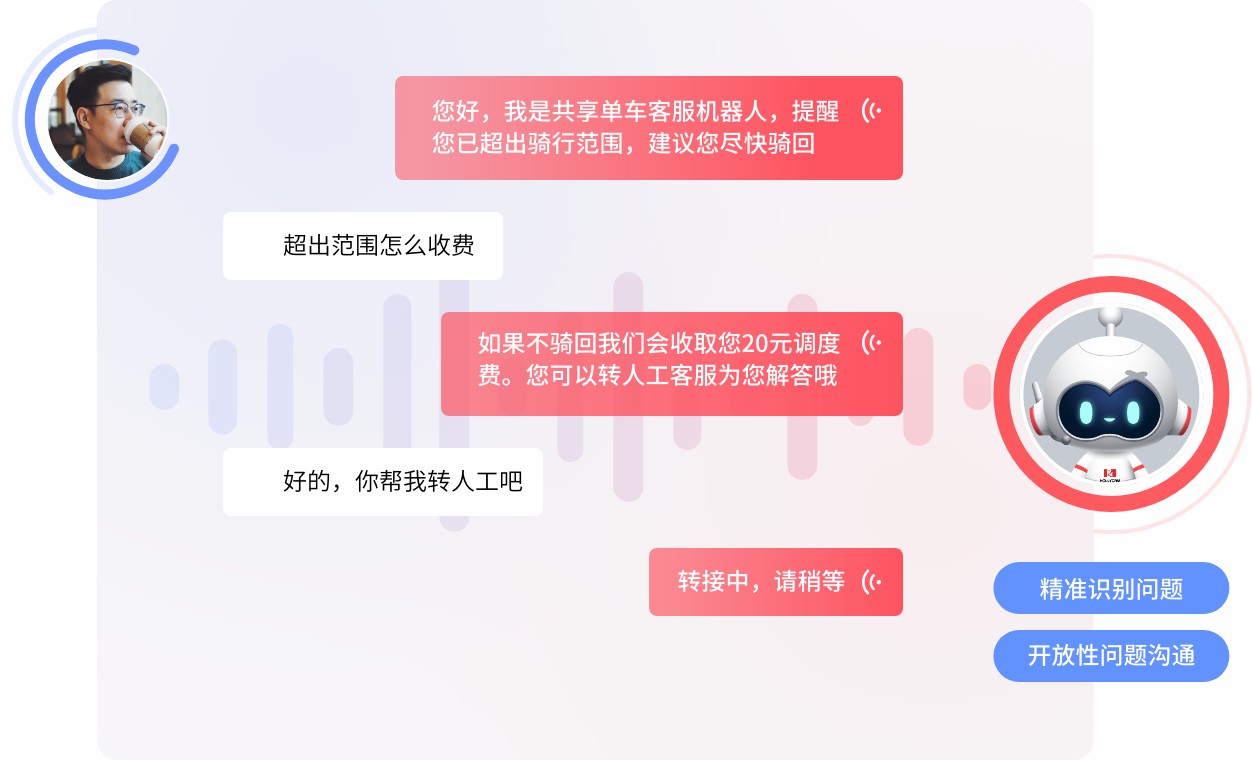

合力亿捷凭借其 MPaaS Agent 编排平台和强大的多引擎融合技术,成功解决了大模型应用中普遍存在的延迟和连贯性问题,为企业构建了真正“听得准、回得快、说得自然”的 AI 数字员工,确保在任何业务场景下都能提供标杆级的客户联络体验。